Junto al despegue de la tecnología, en concreto de la inteligencia artificial, han surgido nuevas preocupaciones relacionadas con su impacto en la sociedad, en los valores y en la ética. La tecnología no es buena o mala en sí misma, depende de cómo se utilice. Es importante determinar la responsabilidad de la persona detrás de la máquina y el criterio que debe guiar la actividad de un robot cuando se enfrenta a un dilema ético.

Autoras: CLARA LÓPEZ Y HELENA CEBRIÁN. Tecnología y Humanismo.

Las aplicaciones de la inteligencia artificial (IA) son cada vez más numerosas, desde la operadora virtual o las acciones que genera un chatbot, hasta las decisiones que deben tomar los coches autónomos. Pero ¿cuál es la secuencia de razonamiento, las reglas que deben definir el comportamiento de un robot ante determinadas cuestiones?

El criterio ético no es algo universal ni preestablecido. Este principio podría variar de unas personas a otras en función de factores sociales y culturales, o de su nivel económico. Esta realidad se pone de manifiesto especialmente con la irrupción de la IA: con el aprendizaje automático es posible hacer que dos máquinas con el mismo código, en contextos distintos, puedan dar respuestas diferentes a la misma situación. Todo depende de la información que se introduzca como muestra de la realidad.

Moral Machine ha puesto en evidencia cómo “lo correcto” también admite variaciones

MORAL MACHINE

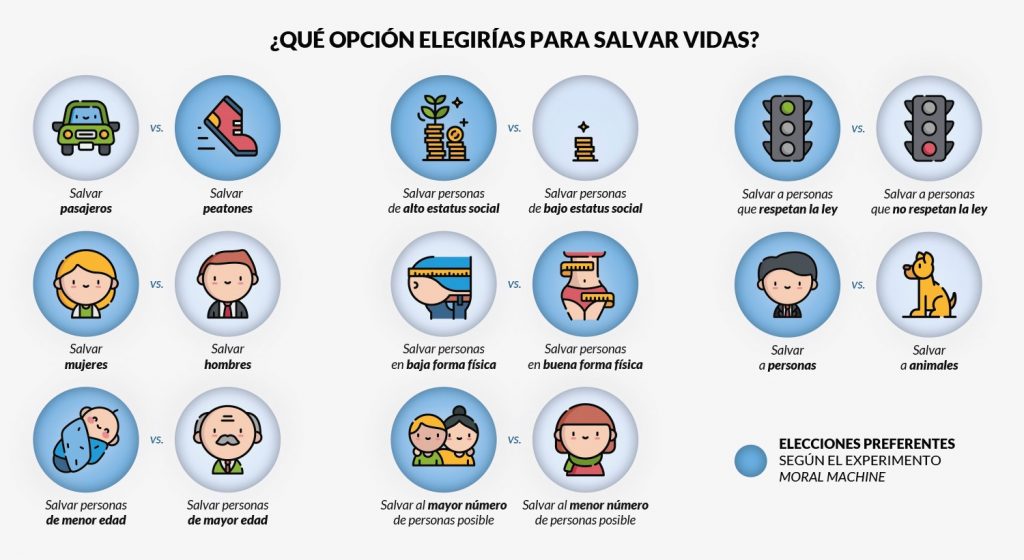

Para analizar las diferencias de criterio ético, el MIT Media Lab ha realizado el experimento Moral Machine. Se trata de un juego de coches autónomos que imita el llamado dilema del ferrocarril. Se plantean nueve situaciones en las que hay vidas en peligro y se analiza cómo se toma la decisión de salvar a unas personas sobre otras y qué criterios utilizan. El estudio se hizo viral y en tres años se obtuvieron más de cuarenta millones de respuestas de hasta 233 países.

Desde luego, los resultados pusieron en evidencia cómo “lo correcto” también admite variaciones culturales. Más allá de las preferencias globales, los investigadores descubrieron que las decisiones variaban sensiblemente en función de los países, y que, además, estaban relacionadas con la cultura y el nivel social y económico. De esta forma, países con culturas muy colectivistas, como China y Japón, eran menos proclives a salvar la vida del joven sobre la persona mayor. El profundo respeto a los ancianos en estas sociedades impacta sin duda en su criterio o predisposición ante este dilema ético.

Países con mayor proximidad física tendían a tomar decisiones similares, con tres grupos dominantes: el Oeste, el Este y el Sur del mundo. La investigación muestra asimismo interesantes conclusiones en países donde ya se está probando el vehículo autónomo, por el posible impacto de este tipo de análisis sobre los reguladores y fabricantes. En ese sentido, por ejemplo, en países como China, los ciudadanos son mucho más partidarios de usar vehículos autónomos siempre y cuando los protejan a ellos frente a los peatones.

Figura 1. Preferencias identificadas en las más de cuarenta millones de respuestas recibidas en el experimento Moral Machine.

MARCOS ÉTICOS

Al margen de este experimento dirigido por el MIT, políticos, industria y reguladores deberían plantearse cuál es el marco de comportamiento ético con el que van a dotar a las máquinas autónomas del futuro. La inercia del desarrollo económico va por delante, pero la ética y la legislación deberían acompañarla.

Las teorías que comúnmente se han venido utilizando para valorar si un determinado desarrollo tecnológico estaba acorde a la ética han sido tres:

- La teoría kantiana del imperativo categórico. En ella, una acción es recta cuando los motivos que subyacen en ella son rectos, y cuando las personas son consideradas como fines y no como medios. En ese sentido, si nuestra intención al programar un coche autónomo es correcta, las conclusiones no deberían ser juzgadas negativamente.

- La teoría utilitarista de Bentham y Mill. Lo que importa son los resultados y, por tanto, el único criterio con validez es conseguir salvar el mayor número de vidas posible.

- La teoría de la justicia distributiva de John Rawls. Por último, en la justicia distributiva se deben garantizar las libertades individuales y lograr el mayor beneficio posible para los más marginados de la sociedad. En este caso, se favorecería salvar al pobre sobre el rico.

REGULAR LA CONVIVENCIA

Independientemente de la doctrina que se siga, se hace necesario valorar no solo la tecnología sino también cómo se utiliza, y asignar responsables que asuman las consecuencias de los actos. Para incorporar los valores morales al uso de la tecnología es necesario recuperar una serie de principios básicos y atemporales, principios como la convivencia pacífica, en este caso entre robots y humanos.

En ese sentido, las leyes que propuso Isaac Asimov en 1942, muy novedosas para la época, están sirviendo de inspiración en el contexto actual. Es el caso de las que ha propuesto recientemente la Unión Europea, que completan y amplían las que propuso el prolífico autor estadounidense de origen ruso. Aunque aún se encuentran en fase de debate por parte de la Comisión Europea, el regulador propone lo siguiente:

- Los robots tendrán un interruptor de emergencia. Esta medida está destinada a evitar cualquier situación de peligro impredecible en el futuro, que pueda ser generada por la posibilidad de que las máquinas aprendan y se escapen de nuestro control.

- Los robots no podrán hacer daño a los seres humanos. La ciencia tiene que estar al servicio del hombre, de modo que no se permitirá la creación de máquinas cuyos fines sean atacar o destruir a los seres humanos.

- No podrán generarse relaciones emocionales con robots. Esta norma quiere recordar que la inteligencia artificial no puede sentir afecto ni emociones, por tanto, no se debería permitir la generación de ningún vínculo emocional con los robots.

- Los de mayor tamaño deberán tener seguro obligatorio. Dependiendo del tamaño, y por tanto del riesgo de causar accidentes o daños materiales, la UE propone que aquellos de mayor tamaño deban contratar obligatoriamente con un seguro de funcionamiento.

- Derechos y obligaciones. Este aspecto es el que más interés ha suscitado, ya que incluye la posibilidad de que estos derechos y obligaciones puedan desplazarse a sus creadores o propietarios. Con el desarrollo de la IA se puso sobre la mesa la posibilidad de dotar a los robots de personalidad jurídica, con el objetivo de depurar la responsabilidad de los fabricantes o de los desarrolladores y que la propia máquina fuera capaz de reparar el daño que causara. Sin embargo, esta es una propuesta muy polémica ya que muchos expertos consideran que es innecesaria, puesto que, al fin y al cabo, la tecnología aún no tiene tal capacidad de autoaprendizaje. Asimismo consideran que no es ético, ya que detrás de la máquina están las decisiones de una persona.

- Pagar impuestos. Una de las consecuencias de la creciente incorporación de las máquinas en los procesos de producción es la eliminación de numerosos puestos de trabajo. El legislador comunitario busca el modo de mitigar el impacto de los robots sobre el empleo, así como beneficiar a los organismos recaudatorios. La contribución de estas máquinas a la seguridad social permitirá dotar de un presupuesto para subvencionar a las personas que pierdan su puesto de trabajo por la popularización de la robótica.

Las empresas deberán evaluar los resultados de la IA para extender su aportación de forma proporcional. Asimismo, ante la posibilidad de que se reduzca el empleo (humano) de forma considerable, se plantea la posibilidad de implantar la denominada renta básica universal (RBU).

Los tecnólogos deben adquirir la formación necesaria en valores éticos

Antes de que la inteligencia artificial se extienda al común de los mortales, se hace necesario dotarla de la parte sociológica y regulatoria. Cada vez es más importante que ingenieros y desarrolladores se aproximen al ámbito de las ciencias sociales, así como que antropólogos, sociólogos y juristas se interesen por la tecnología. Así, a la hora de diseñar el comportamiento de la máquina se podrá aportar un contexto completo con conocimiento de todos los campos, técnicos y sociales.

Cada vez resulta más crítico que los creadores de tecnología cuenten con la adecuada formación en valores éticos para que tengan en cuenta las malas prácticas que se puedan derivar. Es evidente que la IA, en manos de terroristas o criminales, puede convertirse en un arma muy peligrosa: ciberataques de origen desconocido, manipulación de datos, creación de contenido falso o incluso de armas autónomas de destrucción masiva, entre otros riesgos.

Asimismo, las instituciones deben establecer sistemas para evitar los daños sociales, o para ofrecer protección ante los que se puedan causar. Con este fin, se debe fomentar la colaboración entre investigadores y legisladores, crear marcos normativos y éticos o definir códigos de mejores prácticas. Otro aspecto crítico sería el de la concentración financiera, que habría que evitar para que no derive en un uso arbitrario de la tecnología que hace posible la IA.

Si la innovación está al servicio de las personas, debe perseguir un fin que vaya más allá de aspectos puramente económicos. La extraordinaria capacidad de aprendizaje de las máquinas es una variable cada vez más importante en nuestras vidas; si se les enseña, estos seres podrían encargarse de muchas de las tareas que realiza un ser humano, y hacerlo mucho mejor.

Incluso, gracias a su objetividad, podrían llegar a tomar decisiones más “éticas” que los propios humanos. Por ejemplo, en las variaciones del coche autónomo, si en uno de los carriles estuviera el hijo de quien decide, el criterio ético se perdería, mientras que el robot tomaría siempre una decisión correcta y aséptica.

SUJETO MORAL

Pero una de las claves evidentes en este escenario es si se puede considerar a las máquinas como sujetos de juicios éticos, es decir, si podemos atribuirles un delito o una falta. ¿Tienen o tendrán algún día responsabilidad jurídica? El verdadero cambio de paradigma se produciría si pretendemos diseñar seres inteligentes que algún día lleguen a ser autónomos y, por tanto, a responder de sus actos al margen de sus dueños o diseñadores.

De momento, esto es ciencia ficción, una película más dentro del género futurista que tantos éxitos de taquilla ha generado. Por detrás subyace la pregunta de si debemos, en cualquiera de los casos, desplazar nuestra característica más humana como sujetos de actos morales, y perder por tanto la autoría de lo que sucede en nuestro entorno.

Recent Comments